Кластеризатор на основе нейронной сети Кохонена.

Евгений Борисов

пятница, 7 февраля 2014 г.

1 Введение

Кластеризация или естественная классификация это процесс объединение в группы объектов, обладающих схожими признаками. В отличие от обычной классификации, где количество групп объектов фиксировано и заранее определено набором идеалов, здесь ни группы и ни их количество заранее не определены и формируются в процессе работы системы исходя из определённой меры близости объектов.

Кластеризация применяется для решения многих прикладных задач: от сегментации изображений до экономического прогнозирования и борьбы с электронным мошенничеством.

Существует несколько основных методов разбиения групп объектов на кластеры. В данной статье описан кластеризатор на основе нейронной сети Кохонена.

2 Нейронная сеть Кохонена

Искусственная нейронная сеть Кохонена [1] или самоорганизующаяся карта признаков (SOM) была предложена финским исследователем Тойво Кохоненом в начале 1980-х годов.

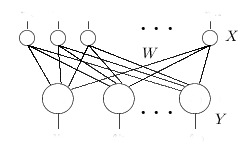

Она представляет собой двухслойную сеть (рис.1). Каждый нейрон первого (распределительного) слоя соединен со всеми нейронами второго (выходного) слоя, которые расположены в виде двумерной решетки.

Нейроны выходного слоя называются кластерными элементами, их количество определят максимальное количество групп, на которые система может разделить входные данные. Увеличивая количество нейронов второго слоя можно увеличивать детализацию результатов процесса кластеризации.

2.1 Функционирование сети

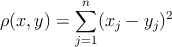

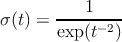

Система работает по принципу соревнования [2] – нейроны второго слоя соревнуются друг с другом за право наилучшим образом сочетаться с входным вектором сигналов, побеждает тот элемент-нейрон, чей вектор весов ближе всего к входному вектору сигналов. За меру близости двух векторов можно взять квадрат евклидова расстояния(1). Таким образом, каждый входной вектор относится к некоторому кластерному элементу.

| (1) |

2.2 Обучение сети

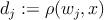

Для обучения сети Кохонена используется соревновательный метод[1, 2]. На каждом шаге обучения из исходного набора данных случайно выбирается один вектор. Затем производится поиск нейрона выходного слоя, для которого расстояние между его вектором весов и входным вектором - минимально.

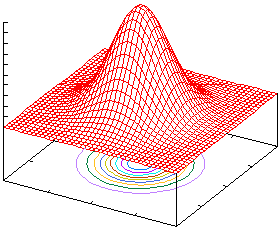

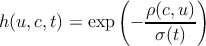

По определённому правилу производится корректировка весов для нейрона-победителя и нейронов из его окрестности, которая задаётся соответствующей функцией окрестности. В данном случае в качестве функцией окрестности была использована функция Гаусса (2).

| (2) |

где u - номер нейрона в двумерной решетке второго слоя сети, для которого

вычисляем значение h;

c - номер нейрона-победителя в двумерной решетке второго слоя сети;

t - параметр времени;

Радиус окрестности h должен уменьшаться с увеличением параметра времени .

Алгоритм обучения сети Кохонена выглядит следующим образом:

- Инициировать матрицу весов малыми случайными значениями (на отрезке [-1,1]).

- Построить очередь из элементов входного множества,

расположив их в случайном порядке,

пометить их все как необработанные. - Выбрать первый необработанный элемент x из очереди.

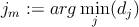

- Для каждого выхода j вычислить расстояние dj (1) между его вектором

весов wj и входным вектором x.

- Найти номер выходного нейрона jm с минимальным расстоянием dj

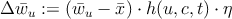

- Вычислить изменение весов ΔW = {Δu} для всех нейронов u выходного

слоя

(3) где

c - номер (пара индексов) нейрона победителя jm в двумерной решетке второго слоя;

u - номер (пара индексов) нейрона с вектором весов u в двумерной решетке второго слоя;

u - вектор весовых коэффициентов связи входного слоя и выходного нейрона номер u;

- текущий вектор входов сети;

h(u,c,t) - значение функции окрестности для нейрона номер u в момент времени t;

η - коэффициент скорости обучения; - скорректировать матрицу весов

- пометить элемент входной очереди x как обработанный

- если в очереди остаются не обработанные точки

то переход на п.3 - если критерий остановки обучения не достигнут

то переход на п.2 - конец

В качестве критериев останова процесса обучения можно использовать следующие:

- Количество полных циклов обучения ограничено константой, например количество циклов равно количеству элементов во входном множестве.

- Выход сети стабилизируется, т.е. входные вектора не переходят между кластерными элементами.

- Изменения весов становятся незначительными.

3 Реализация

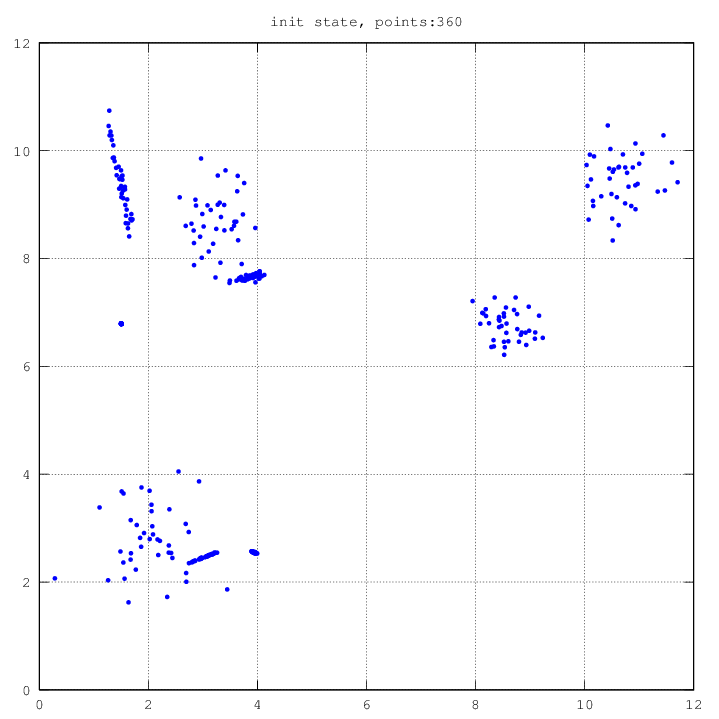

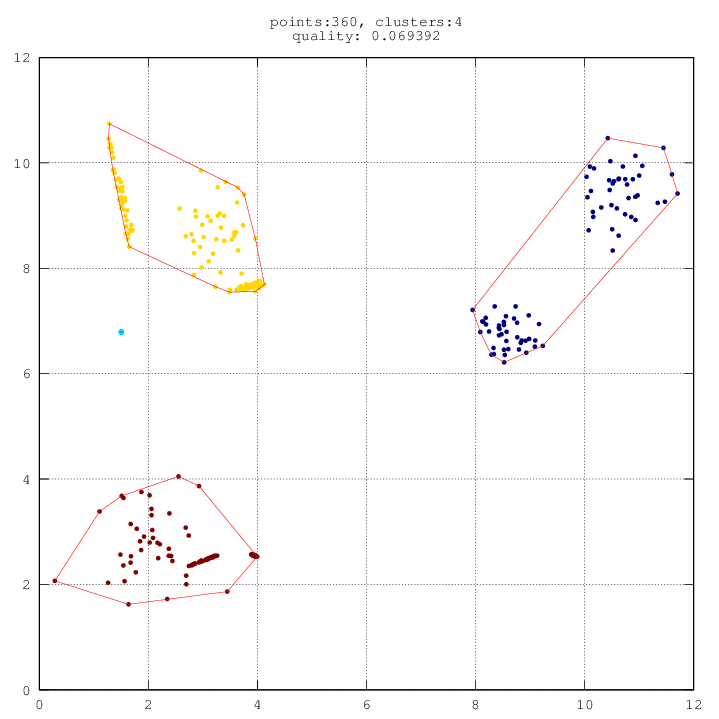

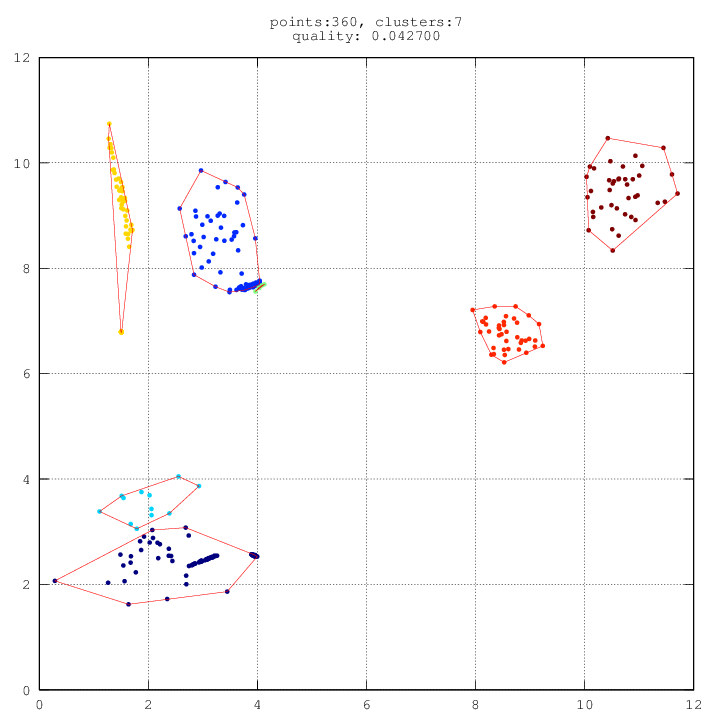

Результат работы алгоритма зависит от начальных значений его параметров.

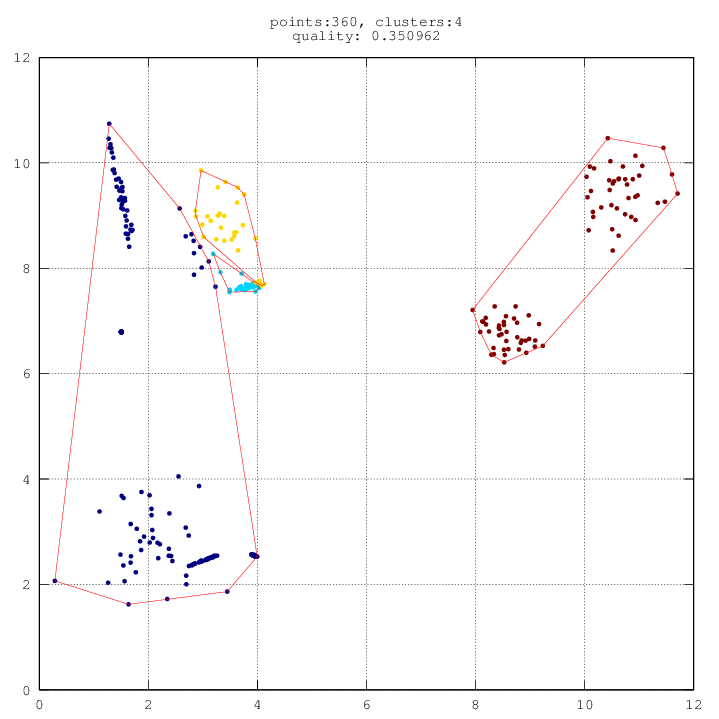

Определим функцию оценки Q качества работы кластеризатора.

c – количество кластеров;Для получения наилучшего результата можно несколько раз выполнить алгоритм кластеризации, после чего выбрать результат с наименьшим значением.

di – среднее внутрикластерное расстояние;

do – среднее межкластерное расстояние;

|

|

|

|

Реализация в системе Octave [ здесь ].

Реализация на языке C [ здесь ].

Список литературы